三国志·战棋版AI战力揭秘!历时40天,基于深度强化学习打造无监督三棋棋王,V0与V0.5版本最强武将、技能、五人组全曝光。荀彧登顶胜率之王,与成关键技!项目暂歇,诚邀同好交流优化,共探AI+策略游戏的无限可能!三国志战棋版 AI攻略

不明白为何贴吧审核未通过

历时约40天,由我独立完成的基于深度强化学习的无监督三棋棋王训练项目,现已发布V0与V0.5版本,成功筛选出最强五人组合,并确定了胜率最高的武将阵容。

发帖旨在寻找志趣相投的朋友,共同交流完善该项目(纯属娱乐),因后续需准备NIPS,时间较为紧张。

忙着赶项目截止日期,还得抽空打游戏,这项目估计得先放一放了。

武将数据库分为两个版本:一是依据最后一次内测的v0版,二是根据最近官方更新的v0.5版。

注意:

武将不包含:

召唤张角、张宝、娄圭、刘晔、袁绍五人前来。

邹氏抱怨睡眠困扰

戏志才、黄月英、严颜和典韦这些武将个人认为实用性不高,技能代码复杂,训练成本虽可降低,但整体效果有限,其中严颜或许稍有作用。

不擅长撒豆成兵类召唤技能,机制复杂数值难控;暴戾无仁类设定也较棘手,写作过程颇为费力。

1. 先放结论:

荀彧在两个版本中胜率均居首位

V0版中提升胜率最显著的技能为

V0.5版本中该技能已移除,影响胜率最高的变为

荀彧刘备董卓张辽庞德组合胜率登顶,内测高玩能来点评下这阵容吗?

最强五人组曝光,胜率登顶,战报即将揭晓,敬请期待!

影响胜率的关键技能由最高注意力值决定

2. 模型简介:

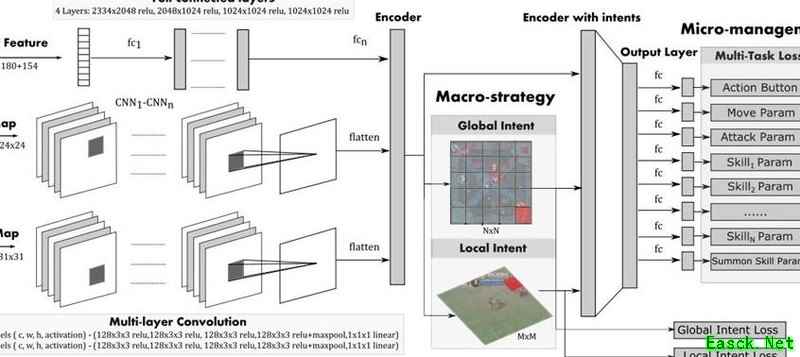

强化学习在DOTA2(OpenAI Five)和王者荣耀(叶等,2020;高某等,2021,腾讯牛X!)等复杂游戏中已展现出卓越性能。受此启发,我基于类似架构搭建模型,在保留核心结构的同时,剔除了部分视觉输入特征,并引入多项适配新游戏机制的改进:包括将战场离散化为棋盘形式以简化状态空间,采用回合制行动模式(实现起来比较简单),以及设计了限定可选技能数量的23技能选择机制。此外,借鉴DeepMind在军棋项目中提出的基于纳什均衡的策略思想,将其融入决策过程,通过自我对弈的方式驱动强化学习训练,最终构建出能够在该环境中自主进化、持续优化策略的智能体。整个框架依托自博弈不断生成高质量数据,实现策略网络的迭代提升。

系统针对62名英雄中的44个S级技能,进行了约2.73×10次训练,V0版本累计训练约27天。

在训练V0.5时,为简化结果,仅采用基于V0版本排名前20的武将和前30的技能进行训练。

强化学习模型结构所示(内行皆知)

移除了小地图,因我将整个棋盘视为完整的局部地图。

采用简单的自注意力机制,提取英雄二、三技能选择相关的键与查询信息。

目前存在一个漏洞,训练未包含A级战法,因其消耗成本过高。

公测后需收集数据优化伤害公式,机器智能背后离不开大量人工投入。

由于涉及利益关系,半年内暂不开源代码,但会与项目成员共享,共同优化完善,望理解。

我手头仅有四块A100可用。

对本项目或其结论感兴趣的朋友们,欢迎积极留言,一起交流探讨,期待与大家深入互动!

有没有人不参加赛事服,第二天进游戏的?可以带我一下吗?(超过150人的大团就算了)